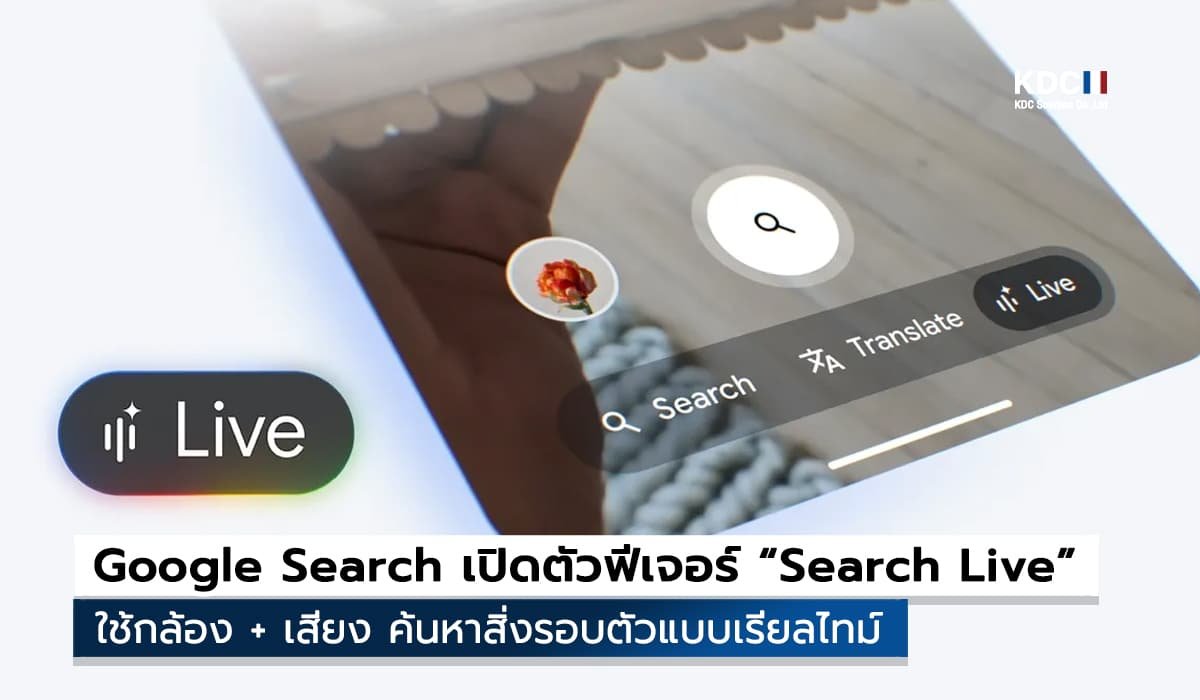

Google ยกระดับประสบการณ์ค้นหาข้อมูลบนมือถือ เปิดตัว ฟีเจอร์ Search Live ที่ให้ผู้ใช้ใช้กล้องส่องสิ่งรอบตัว พร้อมถามคำถามด้วยเสียงได้ทันทีแบบเรียลไทม์ เป็นการต่อยอดจาก Project Astra ที่เคยเปิดให้ทดลองใช้งานผ่าน Google Labs มาก่อนหน้านี้ โดยล่าสุดฟีเจอร์นี้เริ่มเปิดให้ใช้งานจริงแล้วใน สหรัฐอเมริกา ผ่าน AI Mode ของ Google Search

วิธีใช้งาน Search Live

เพียงเปิด แอป Google บนมือถือ Android หรือ iOS จะพบปุ่ม “Live” บนแถบค้นหา เมื่อกดแล้วจะเข้าสู่โหมดกล้อง จากนั้นผู้ใช้สามารถ ชี้กล้องไปยังวัตถุหรือสิ่งรอบตัว พร้อมพูดถามคำถาม เช่น ส่องกล้องไปที่พืชเพื่อถามว่า “นี่คือต้นอะไร” หรือชี้ไปที่อุปกรณ์อิเล็กทรอนิกส์เพื่อหาวิธีใช้งาน ฟีเจอร์นี้ทำงานคล้าย Gemini Live แต่ถูกผสานเข้ามาในแอป Search โดยตรงเพื่อให้เข้าถึงง่ายกว่า

นอกจากนี้ Google Lens ก็รองรับ Search-Live ด้วยเช่นกัน โดยเพิ่มปุ่ม Live ให้สามารถเปิดใช้งานผ่านกล้องในลักษณะเดียวกัน

การมาถึงของ Search-Live ถือเป็นก้าวสำคัญของ Google ในการผสมผสาน AI เข้ากับการค้นหาข้อมูลแบบเห็นภาพและเสียงพร้อมกัน ช่วยให้ผู้ใช้ค้นหาได้สะดวก รวดเร็ว และเป็นธรรมชาติมากขึ้น โดยมีแนวโน้มจะขยายให้ใช้งานได้ในประเทศอื่นในอนาคต หลังจากเก็บข้อมูลและความคิดเห็นจากผู้ใช้ในรอบแรกเรียบร้อยแล้ว

tags : Google