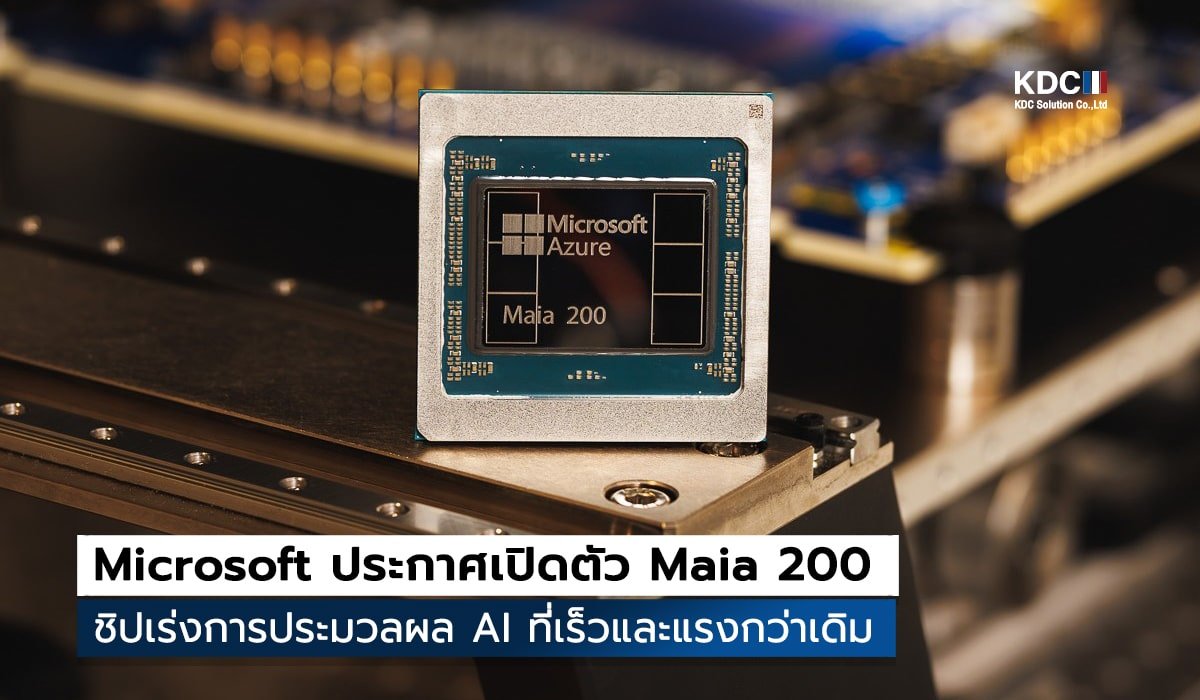

สมรภูมิชิป AI เดือดทะลุปรอท! Microsoft ประกาศเปิดตัว Maia 200 ชิปเร่งการประมวลผล AI รุ่นที่ 2 ที่ซุ่มพัฒนาเองเพื่อยึดบัลลังก์ Cloud Inference โดยชูจุดเด่นที่ “ความคุ้มค่าและความแรง” ที่ปรับแต่งมาเพื่อระบบ Azure โดยเฉพาะ พร้อมท้าชนยักษ์ใหญ่อย่าง NVIDIA Blackwell ในแง่ประสิทธิภาพการใช้งานจริง

Microsoft เลือกใช้เทคโนโลยีที่ล้ำหน้าที่สุดเพื่อสร้างความได้เปรียบในเชิงวิศวกรรม

ผลิตด้วยเทคโนโลยี 3 นาโนเมตรจาก TSMC บรรจุทรานซิสเตอร์กว่า 1.4 แสนล้านตัว ให้ประสิทธิภาพการจัดการพลังงานที่เหนือกว่า โดยคุมการใช้ไฟไว้ที่ 750 วัตต์ (ในขณะที่คู่แข่งอาจพุ่งไปถึง 1,000 วัตต์)

อัดแน่นด้วยหน่วยความจำ HBM3e ขนาด 216GB (แบนด์วิดท์ 7 TB/s) พร้อม SRAM บนชิปอีก 272MB เพื่อกำจัดคอขวดในการส่งข้อมูลของโมเดลขนาดใหญ่

ทำความเร็วในระดับ FP4 ได้สูงถึง 10 PetaFLOPS ซึ่ง Microsoft เคลมว่าแรงกว่า Amazon Trainium รุ่นล่าสุดถึง 3 เท่า!

รัน GPT-5.2 ได้นิ่งและถูกลง

หัวใจสำคัญของ Maia 200 ไม่ใช่แค่ตัวเลขบนหน้ากระดาษ แต่คือ “ความคุ้มค่า” ในการใช้งานจริง

ให้ประสิทธิภาพต่อราคา (Performance per Dollar) ดีขึ้นถึง 30% เมื่อเทียบกับฮาร์ดแวร์รุ่นเดิมใน Azure

ออกแบบมาให้รองรับโมเดลระดับล้านล้านพารามิเตอร์อย่าง GPT-5.2 และระบบ Microsoft 365 Copilot ได้อย่างไหลลื่น ช่วยลดต้นทุนการประมวลผลต่อโทเค็น (Token) ให้ต่ำลงมหาศาล

รองรับการเชื่อมต่อแบบ Cluster ได้สูงสุดถึง 6,144 ตัว ผ่านมาตรฐาน Ethernet ที่ปรับแต่งมาเป็นพิเศษ

การเปิดตัว Maia 200 ในช่วงต้นปี 2026 นี้ส่งสัญญาณชัดเจนถึงทิศทางของ Big Tech

Microsoft กำลังลดการพึ่งพาชิปจาก NVIDIA โดยการสร้าง Ecosystem ของตัวเองที่ควบคุมได้ตั้งแต่ชิปไปจนถึงแอปพลิเคชัน

ในขณะที่โลกเน้นการ “ฝึกฝน” (Training) แต่ Microsoft มุ่งเป้าไปที่การ “ใช้งานจริง” (Inference) ซึ่งเป็นจุดที่สร้างกำไรและส่งผลต่อผู้ใช้ทั่วไปมากที่สุด

การมีชิปที่ออกแบบมาเพื่อ Azure โดยเฉพาะ ทำให้ Microsoft สามารถเสนอราคาบริการ AI ที่แข่งขันได้ดีกว่าคู่แข่งในตลาด Cloud

การมาของ Maia200 คือคำเตือนถึงเหล่านักพัฒนาว่า ยุคของ AI ที่ “แรงแต่แพง” กำลังจะหมดไป และเรากำลังเข้าสู่ยุค AI ที่ “แรงและคุ้มค่า” อย่างเต็มตัว

tags : microsoft